现在网上有很多的部署教程,但是大都是常规模型。对于一些敏感问题,模型一般会拒绝回答。

现在网上有一些未经审查(uncensored)版本的Deepseek R1模型,使用了一种名为abliteration的技术,移除了模型的拒绝机制,除此外部署方式和原版的一模一样,都是通过ollama拉取模型,然后运行。

安装ollama

ollama是一个开源的LLM(大语言模型)运行框架,可以运行各种大语言模型,包括深度求索的Deepseek R1、Meta的llama、 阿里的qwen等等。

ollama的下载地址为:https://ollama.com/download

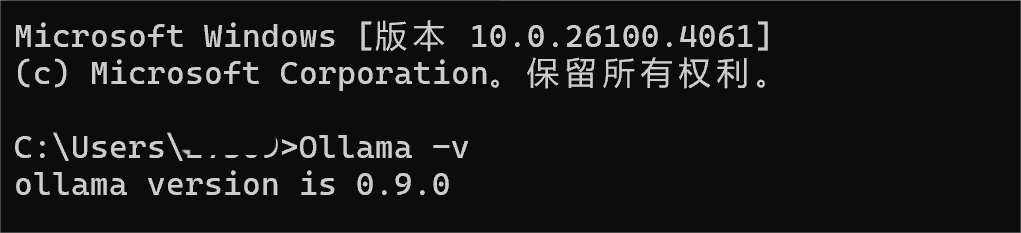

根据自己的操作系统选择对应的版本下载即可。安装完成后打开命令行,输入ollama -v即可确认安装是成功:

ollama是一个命令行工具,常用的命令如下:

ollama pull <模型名称> # 拉取模型

ollama run <模型名称> # 运行模型,模型不存在会自动拉取

ollama ps # 查看正在运行的模型

ollama ls # 列出所有模型

ollama stop <模型名称> # 停止模型

ollama rm <模型名称> # 删除模型推荐1个可以调用ollama的API接口的图形化工具:

- Page Assist(浏览器扩展): https://github.com/n4ze3m/page-assist

这个可以在Edge浏览器或者谷歌浏览器的插件扩展商店下载

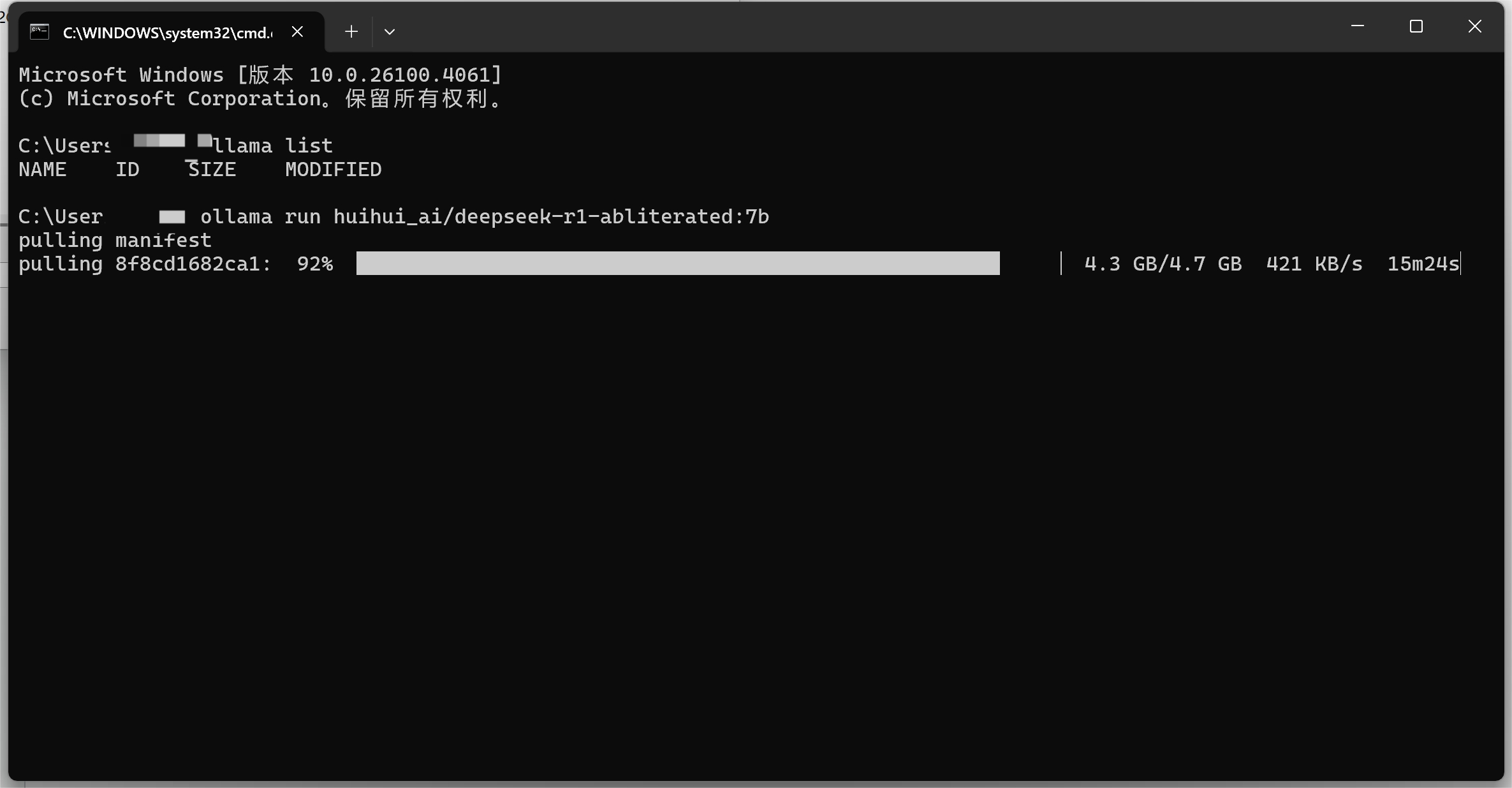

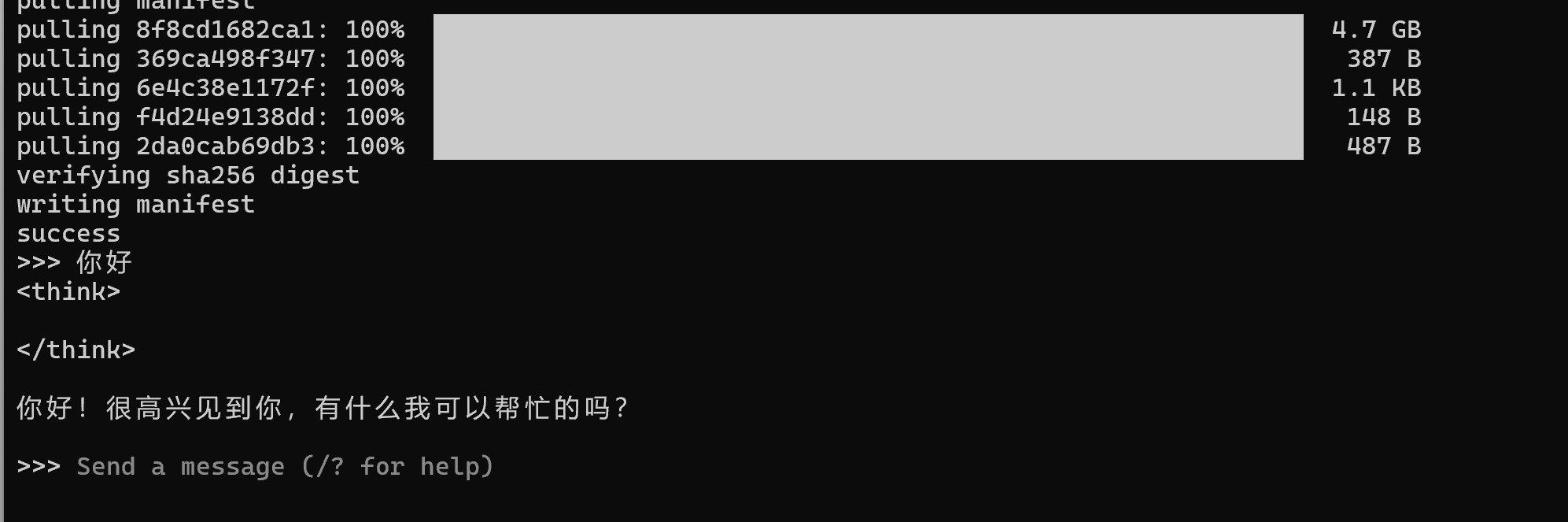

拉取并运行模型

根据自己电脑的配置,选择合适的模型进行下载和运行

ollama run huihui_ai/deepseek-r1-abliterated:7b

ollama run huihui_ai/deepseek-r1-abliterated:8b

ollama run huihui_ai/deepseek-r1-abliterated:14b

ollama run huihui_ai/deepseek-r1-abliterated:32b

ollama run huihui_ai/deepseek-r1-abliterated:70b

下载安装好模型之后,deep seek是运行在CMD里边,这个黑窗口属实不好看,这时咱们就可以用上面推荐的Page Assist(浏览器扩展)图形化工具。

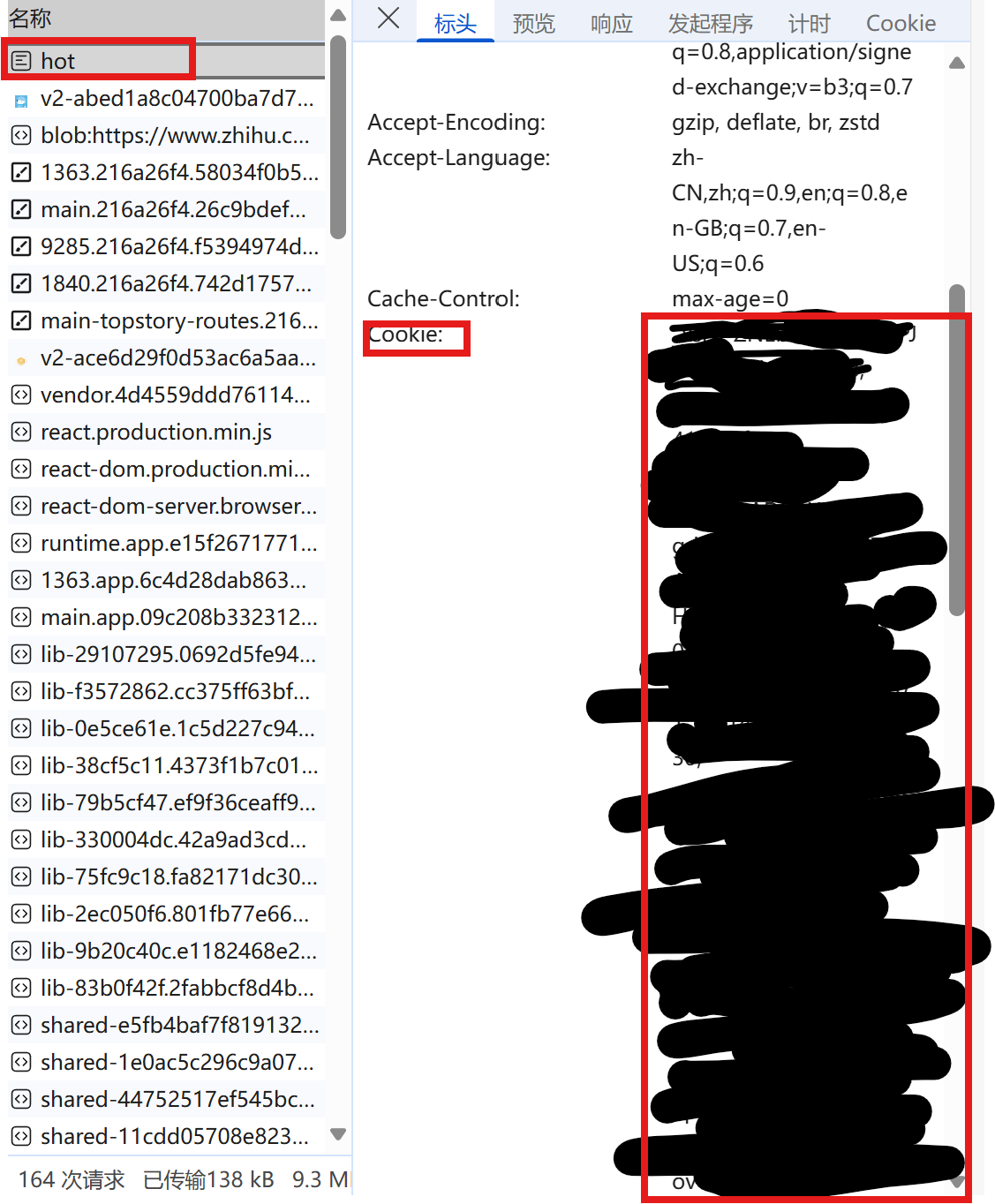

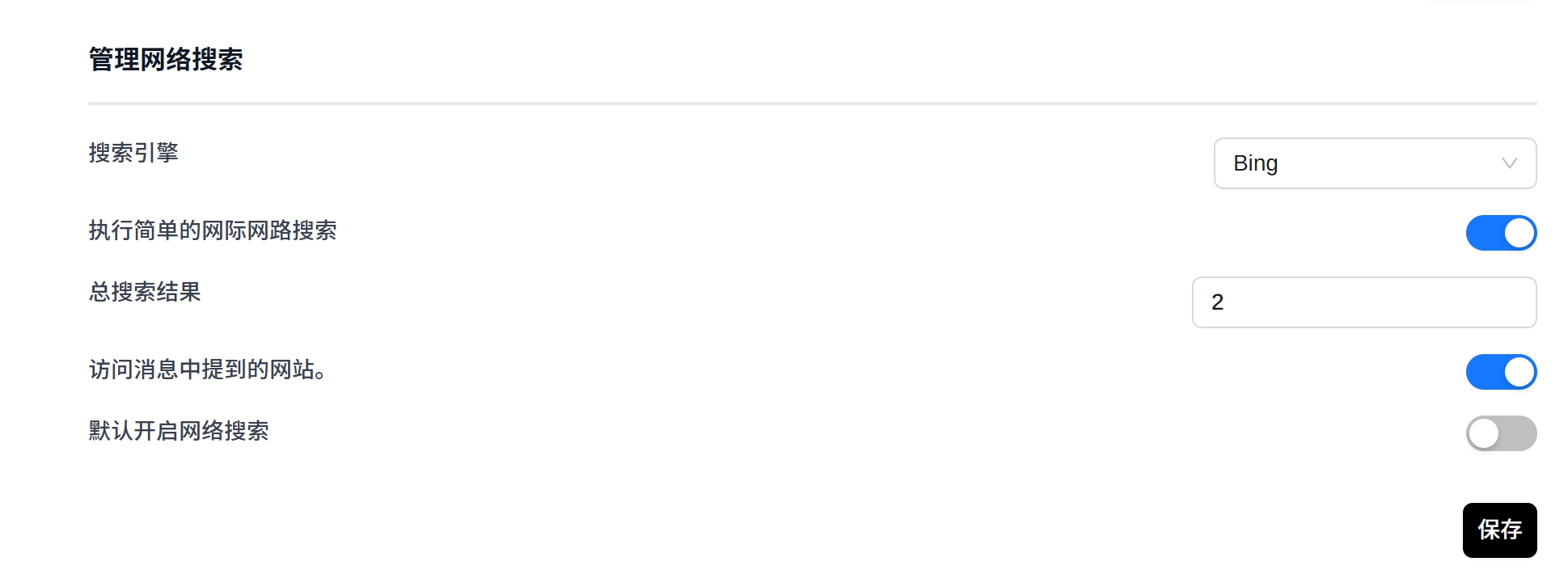

打开插件的设置,在一般设置里搜索引擎修改为bing,这样即使在本地运行的模型也可以使用联网搜索功能。

安装完成后,在Page Assist浏览器插件里就可以运行了

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...